Предсказание вероятностей и преобразование SoftMax

Часто в прикладных задачах требуется хорошо предсказывать не только метку класса , но и вероятность каждого класса Например, в задачах прогноза погоды важно не только предсказать, будет ли ясная погода или дождь, но и вероятность дождя. Ведь даже если она меньше 50%, но близка к ней, то имеет смысл брать зонтик.

Для предсказания вероятностей классов нужно использовать их дискриминантные функции характеризующие степень уверенности классификатора в том или ином классе. Поскольку дискриминантные функции могут принимать произвольные значения - как положительные, так и отрицательные - а сумма дискриминантных функций не обязательно равна единице, то к ним необходимо применить некоторое монотонно-возрастаю�щее преобразование , обеспечивающее два свойства:

-

выходы должны быть неотрицательными;

-

выходы должны суммироваться в единицу.

В качестве такого преобразования используют операцию SoftMax, используемую для перевода ненормированных рейтингов классов в их вероятности:

Как вы думаете, на что влияет параметр ?

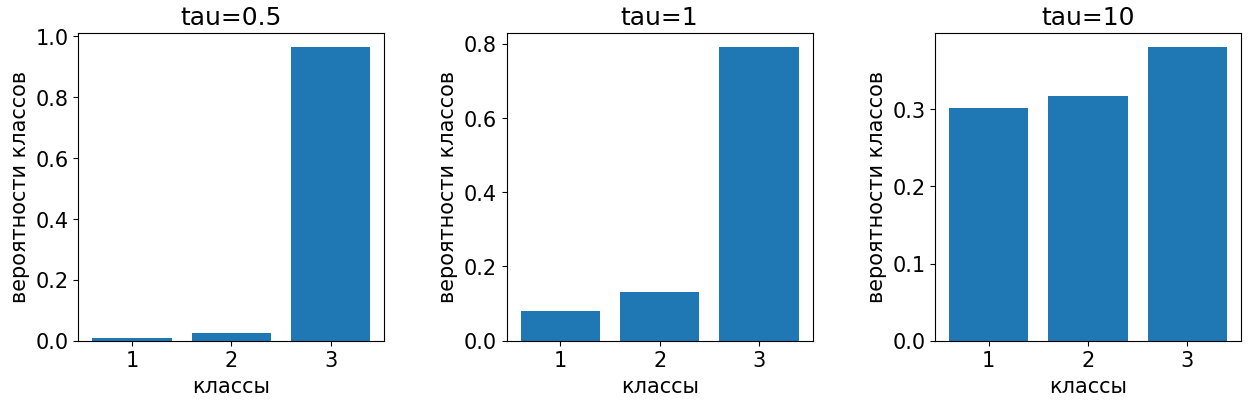

Параметр , называемый температурой (temperature), определяет контрастность получаемых вероятностей. Чем выше, тем метод становится менее чувствительным к индивидуальным различиям дискриминантных функций, результирующее распределение вероятностей становится более близким к равномерному.

И наоборот, чем ниже, тем сильнее SoftMax реагирует на изменения рейтингов, а выходные вероятности становятся более контрастными.

Эти случаи показаны на рисунке:

SoftMax-преобразование можно обобщить, применяя любую монотонно возрастающую функцию , принимающую неотрицательные значения:

В частном случае получим операцию SoftMax.

Детальнее о SoftMax-преобразовании можно прочитать в [1].