Лучший классификатор на ROC кривой

ROC-кривая описывает семейство классификаторов, параметризованных параметром :

Но как выбрать лучший экземпляр этого семейства?

В бинарной классификации , поэтому есть только два типа ошибок:

-

Назначить объекту положительного класса отрицательный класс, что реализуется с вероятностью . Обозначим штраф за такую ошибку .

-

Назначить объекту отрицательного класса положительный класс, что реализуется с вероятностью . Штраф за эту ошибку обозначим .

Тогда средние потери классификатора будут

Отсюда в осях можно получить изолинии потерь (loss isolines), т.е. множество точек (FPR,TPR), приводящих к одинаковому уровню средних потерь :

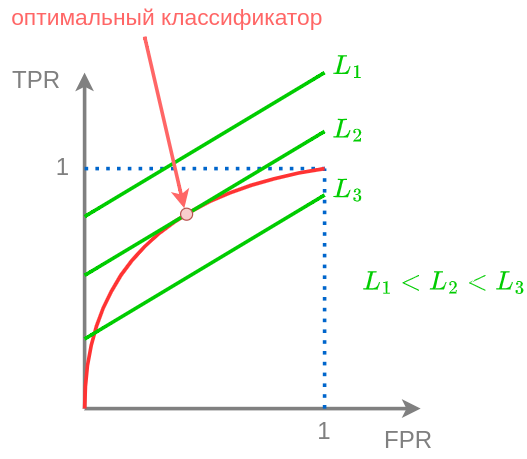

Поскольку полученная зависимость TRP(FPR) линейна, то это будет прямая линия с положительным наклоном, а более высоким линиям будут отвечать более низкие ожидаемые потери, как показано на рисунке:

Отсюда следует, что оптимальным классификатором при заданных парамерах

будет классификатор, соответствующий точке касания изолинии потерь и ROC-кривой.

При изменении одного из этих параметров необязательно перенастраивать модель, а достаточ�но выбрать другую точку на ROC-кривой, т.е. взять классификатор с другим пороговым значением .

Например, в задаче кредитного скоринга в кризис вероятность невозврата кредита существенно вырастает, а для адаптации к этому изменению достаточно лишь изменить порог .