ROC-кривая

Управление готовностью назначать положительный класс

Рассмотрим бинарный классификатор:

Его относительная дискриминантная функция характеризует степень уверенности классификатора в том, что объект принадлежит положительному классу.

Решающее правило можно обобщить, введя порог , с которым производится сравнение:

Чем выше, тем более осторожно классификатор начинает предсказывать положительный класс для тех же самых объектов, и наоборот, для более низких положительный класс назначается более охотно. Это полезный параметр чтобы управлять готовностью назначать объектам положительный класс без перенастройки самой модели.

Рассмотрим задачу кредитного скоринга, в которой для клиентов (объектов ) нужно предсказывать, вернут ли они кредит или нет , на основе чего кредит либо выдаётся, либо нет. Для низких мы более склонны давать кредиты, и это обосновано в периоды экономического подъёма. В периоды же экономического спада разумно выдавать кредиты более осторожно, повысив гиперпараметр . Обратим внимание, что, варьируя порог , мы можем управлять поведением модели в различных экономических ситуациях без необходимости перенастраивать модель.

Меры TPR и FPR

Определим две меры качества бинарной классификации - true positive rate (TPR) и false positive rate (FPR):

где - число объектов положительного и отрицательного класса соответственно. Мера TPR совпадает с ранее изученной мерой Recall. Также её называют recognition rate, поскольку по смыслу она характеризует долю верных (положительных) детекций среди объектов положительного класса. Меру FRP также называют false alarm rate, поскольку она характеризует долю неверных детекций (положительным классом) среди объектов отрицательного класса.

В примере с кредитным скорингом TPR будет измерять долю клиентов, которые могли бы вернуть кредит и мы действительно сочли их кредитоспособными. FPR же будет измерять долю клиентов, которые не способны вернуть кредит, но которых мы ошибочно сочли кредитоспособными.

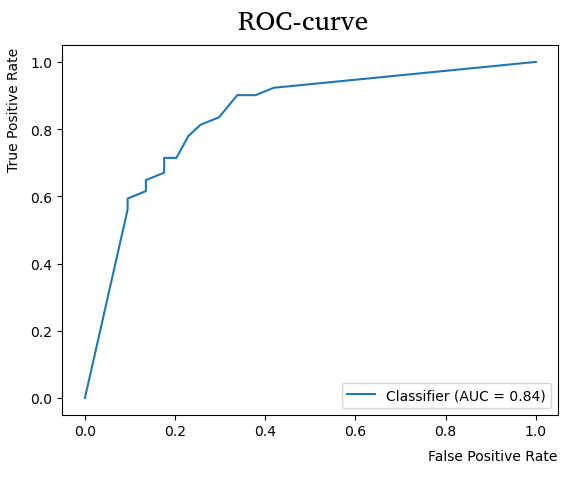

ROC-кривая

ROC-кривая (ROC-curve, receiver operating characteristic) показывает зависимость от при изменении порога . Обе величины, измеряя частоты, изменяются от нуля до единицы по неубывающему закону, как показано на графике:

При высоком классификатор будет очень редко назначать положительный класс - только в тех случаях, когда он очень уверен в положительности класса. Тогда TPR будет близок к нулю (будет мало верно распознанных объектов положительного класса), как и FPR (поскольку положительный класс будет назначаться редко). Если же уменьшать , то частота назначения положительного класса будет увеличиваться, увеличивая и TPR, и FPR, в результате чего мы прочертим ROC кривую.

Чем выше ROC-кривая, тем лучше классификатор, поскольку нам бы хотелось иметь более высокий TPR при том же уровне FPR.

Рассмотрим классификатор, который случайно назначает классы, независимо от вектора признаков , по формуле

где - равномерно распределённая случайная величина на отрезке . Докажите, что ROC-кривая, соответствующая этому классификатору будет прямая TPR=FPR. Существуют ли классификаторы, для которых ROC-кривая проходит ниже этой прямой? Можем ли мы извлечь пользу из таких классификаторов?

Агрегированной мерой качества классификации служит площадь под ROC-кривой, называемая AUC (area under curve).