Локально-линейная регрессия

В традиционной линейной регрессии прогноз строится как линейная комбинация признаков:

где веса находятся из принципа минимизации наименьших квадратов:

Обратим внимание, что формула (1) предполагает глобальную линейную связь между признаками и откликами. Но как быть, если реальная зависимость нелинейна? Один из вариантов - добавлять нелинейные трансформации в число признаков. Другой подход - использовать линейную зависимость, но со своими коэффициентами для каждого объекта , что реализуется в алгоритме локально-линейной регрессии (local linear regression, locally weighted scatterplot smoothing, LOWESS [1]), в которой прогноз также строится по формуле (1), однако параметры находятся по объектам, лежащим недалеко от , за счёт минимизации взвешенной суммы квадратов ошибок:

Как видим, объекты учитываются с весами , где вес каждого объекта определяется близостью к прогнозируемому объекту : чем он ближе, тем его вес больше. Это позволяет вычислять коэффициенты линейной регрессии адаптивно к той точке, в которой нужно построить прогноз. В другой точке зависимость также будет линейной, но уже с другими коэффициентами.

Поэтому прогнозная функция для всевозможных уже будет получаться нелинейной.

Веса вычисляются по тем же формулам, что и веса локально-постоянной регрессии.

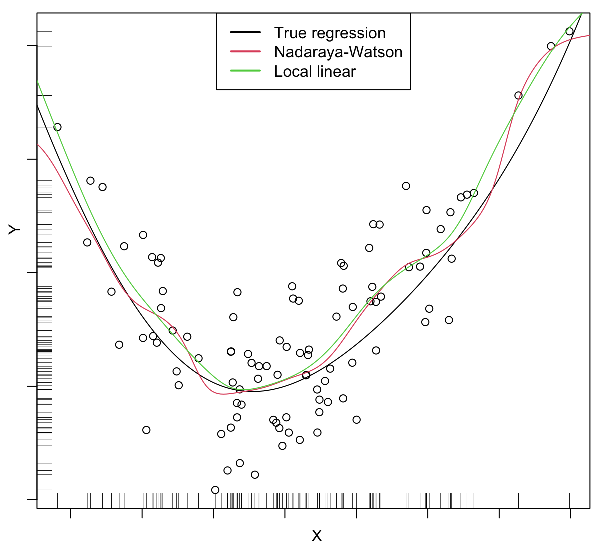

По сравнению с локально-постоянной регрессией, локально-линейный вариант более вычислительно трудоёмкий, поскольку необходимо заново находить минимум (2) для каждого тестового объекта . Зато он более гибкий. В частности локально-линейная регрессия лучше экстраполирует зависимости в областях, где обучающих примеров мало, как показано на рисунке по краям: