Модели LSTM и GRU

Модели LSTM и GRU представляют собой усложнённые версии классической рекуррентной сети и были специально разработаны, чтобы обрабатывать длинные последовательности и �лучше помнить историю из ранее виденных наблюдений.

Эти модели преобразуют входную последовательность в последовательность состояний , использующихся внешними моделями (такими как многослойный персептрон), строящими уже итоговые прогнозы.

И входы, и внутренние состояния являются векторами вещественных чисел.

Гейты в нейронных сетях

Улучшенная память моделей LSTM и GRU достигается заменой многократных перемножений матриц при учёте истории наблюдений операциями взвешенной суммы, где веса суммирования рассчитываются специальными функциями, называемыми гейтами (gates). В русскоязычной литературе их также называют вентилями.

Гейты представляют собой вектора чисел, принимающими значения в отрезке [0,1], и управляют потоками данных, проходящих через нейросеть. Для этого вектора данных поэлементно домножаются на вектора гейтов.

-

Когда значение гейта равно 0, гейт закрыт и информацию не пропускает.

-

Когда значение гейта равно 1, гейт открыт, и информация свободно проходит.

Рассмотрим пример, когда нам нужно обновить состояние по входным данным и известному прошлому состоянию при следующих значениях:

Мы могли бы это сделать, пропустив и через линейное преобразование, как сделано в простейшей рекуррентной сети Элмана. Однако оно предполагает умножение на матрицу, которое будет производиться многократно при итеративной обработке последовательности и настройке сети методом truncated BPTT. Это, в свою очередь, будет приводить к численной неустойчивости, сводящейся либо к тому, что сеть будет очень быстро забывать предыдущие наблюдения, либо их вклад в прогноз будет, наоборот, будет быстро возрастать.

Чтобы решить эти проблемы, операцию умножения на матрицу предлагается заменить на вычислительно более устойчивую операцию взвешенного суммирования, где веса суммирования будут определяться гейтами.

Пусть, для примера, мы хотим обновить состояние на нечётных позициях из входа , а на чётных позициях оставить значения предыдущего состояния .

Это легко реализовать с помощью следующего гейта :

и операции

где обозначает поэлементное перемножение векторов.

В итоге получим следующий результат:

Таким образом, открытые элементы вектора гейта (=1) приводят к обновлению информации, а закрытые (=0) - к её сохранению.

Если информация действительно важна, то её можно сохранять очень долго, что позволяет сети, основанной на гейтах, эффективно учитывать долгосрочные зависимости в данных!

Расчёт значений гейтов реализуется линейными слоями с сигмоидной функцией активации на выходе.

GRU

Модель GRU была предложена в [1]. Формула пересчёта состояния по входу и предыдущему состоянию модели GRU приведена н�иже:

В модели используются два гейта - гейт перезапуска и гейт обновления . В формуле пересчёта они выделены зелёным и красным цветом.

Параметры модели:

-

матрицы ;

-

векторы .

LSTM

Модель LSTM была предложена в [2]. Формула пересчёта состояния по входу и предыдущему состоянию модели LSTM приведена ниже:

В сети используются три гейта, выделенные цветом:

-

гейт забывания ;

-

входной гейт ;

-

выходной гейт .

Дополнительно используется вектор памяти (memory cell) для внутренних вычислений. Выходом сети служит вектор состояния .

Как видно из формул пересчёта, открытый forget-гейт будет приводить не к забыванию памяти , а, наоборот, к сохранению! Поэтому правильнее было бы его назвать "remember gate".

Параметры модели:

-

матрицы ;

-

векторы .

Как видим, у LSTM больше параметров, чем у GRU. Тем не менее, GRU способна моделировать те же особенности поведения, что и LSTM. Итоговый выбор между ними нужно делать на основе сравнения качества работы этих моделей на данных.

Рекомендуется инициализировать вектор смещений единицами, чтобы в самом начале оптимизации сеть помнила всю историю. Если это окажется излишним, то оптимизатор понизит значение смещений.

Примечательно, что модель LSTM, будучи значительно сложнее GRU, была предложена на 17 лет раньше!

Преимущества

Используя гейты, сети GRU и LSTM могут производить следующие действия при обработке текста (как последовательности слов):

-

запоминать информацию, которая была очень давно, например, в начале предложения;

-

игнорировать часть входной информации, которая не релевантна решаемой задаче (например, комментарии или html-тэги);

-

перезапуск�аться "с чистого листа" по достижении логического разрыва в тексте (например, начала новой главы).

Эти же возможности доступны, если применять модели LSTM и GRU к последовательностям других типов данных.

Какие гейты должны быть открыты/закрыты, чтобы GRU и LSTM реализовывали каждый из перечисленных сценариев.

Как и обычные рекуррентные сети, модели GRU и LSTM могут эффективно применяться в режимах many-to-one, one-to-many и many-to-many, а для большей выразительной силы над ними можно производить те же усложнения (наслаивание, проброс связей, двунаправленность, гиперсеть и т.д.), которые мы изучи�ли ранее.

Примеры генерации текстов

Сети LSTM и GRU в задаче языкового моделирования способны генерировать довольно реалистичные тексты.

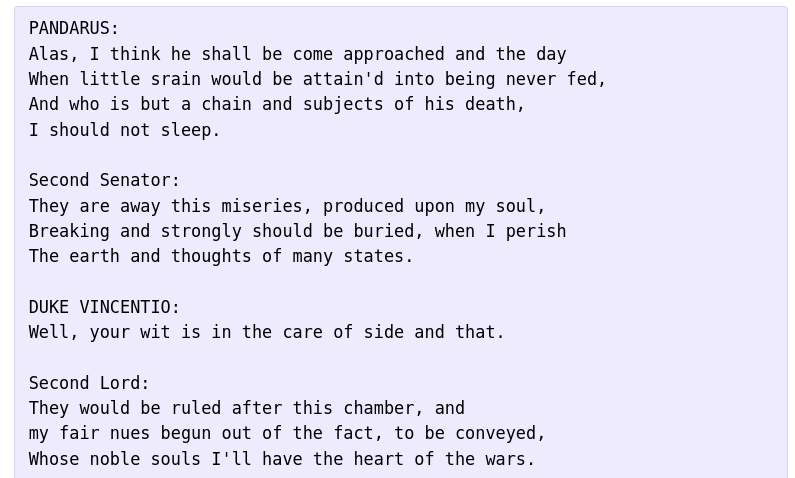

Например, если обучить LSTM на произведениях Шекспира, то можем получить следующий результат [3]:

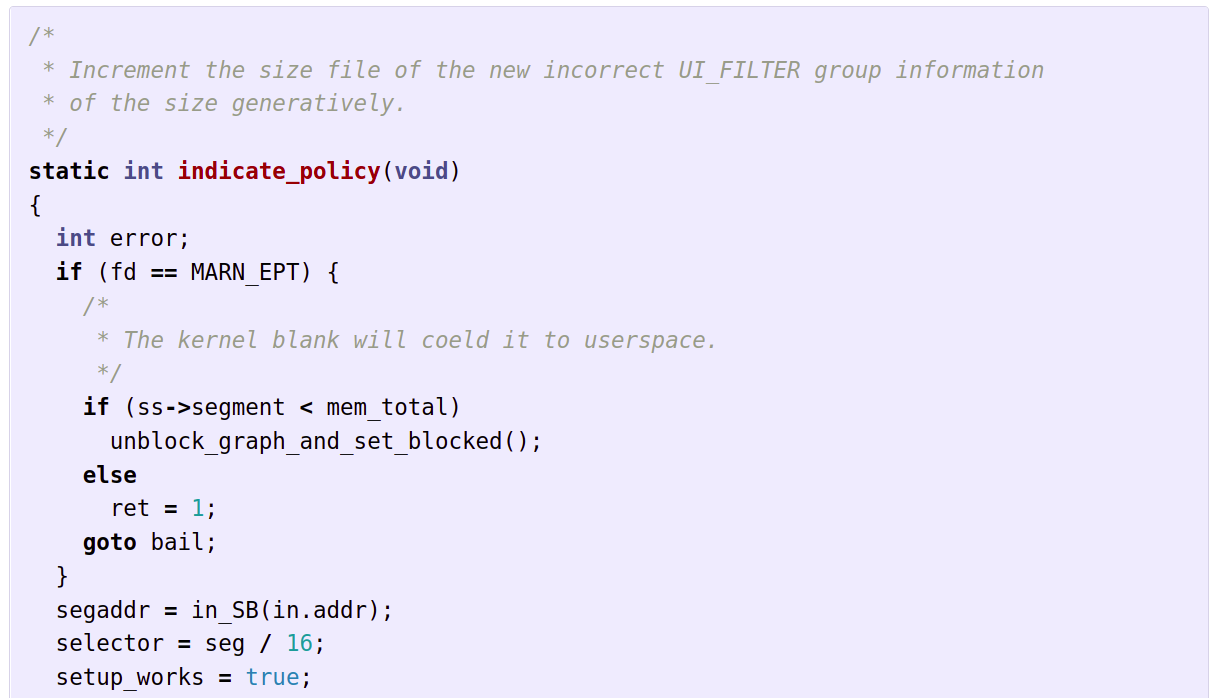

А если обучать LSTM на исходном коде Linux, то сеть будет генерировать новые реалистичные программы [3]:

Реализовав на базе LSTM/GRU схемы one-to-many / many-to-many, можно производить условную генерацию (генерация текста по теме, реализация программы, выполняющей определё�нное действие т.д.). Отметим, что это сложные задачи, которые эффективнее решаются дополнительным подключением механизма внимания / использованием модели трансформера.

Альтернативные более простые подходы

Хотя LSTM и GRU представляют собой стандартные усложнения рекуррентных сетей для лучшего запоминания и учёта давних исторических наблюдений, для полноты обзора отметим и менее популярные, зато более простые подходы по модификации рекуррентной сети Элмана для решения той же задачи.

В [4] предложено инициализировать матрицу пересчёта старого состояния по новому единичной матрицей, а вектор - нулевыми значениями. Во время оптимизации эти параметры могут свободно меняться, однако благодаря подобной инициализации вначале сеть способна помнить всю историю, аккумулируя старые состояния.

В [5] предложено разделить внутреннее состояние на два подвектора: быстро и медленно меняющуюся компоненту. Первая отвечает за адаптацию модели в реальном времени, а вторая - за учёт длительного исторического контекста. Быстро меняющаяся к�омпонента пересчитывается как обычное состояние, но с учётом медленно меняющейся компоненты, которая реализуется экспоненциальным сглаживанием самой себя с новой информацией, а параметр экспоненциального сглаживания выбирается так, чтобы она менялась очень плавно и постепенно.

Литература

- Cho K. et al. Learning phrase representations using RNN encoder-decoder for statistical machine translation //arXiv preprint arXiv:1406.1078. – 2014.

- Hochreiter S. Long Short-term Memory //Neural Computation MIT-Press. – 1997.

- http://karpathy.github.io/2015/05/21/rnn-effectiveness/

- Le Q. V., Jaitly N., Hinton G. E. A simple way to initialize recurrent networks of rectified linear units //arXiv preprint arXiv:1504.00941. – 2015.

- Mikolov T. et al. Learning longer memory in recurrent neural networks //arXiv preprint arXiv:1412.7753. – 2014.