Меры качества прогнозов

Изучим основные меры качества прогнозов семантической сегментации.

Рассмотрим семантическую сегментацию на два класса - целевой объект и фон.

Целевым объектом может быть человек на фотографии, заболевание на рентгеновском снимке и т.д.

Попиксельная точность

Самой простой мерой качества сегментации является попиксельная точность (pixel accuracy), т.е. доля верно классифицированных пикселей. Недостатком этой меры является завышенное качество, когда фон доминирует над целевым классом, что является типичной ситуацией. В этом случае модель будет показывать высокую точность, даже если модель не будет решать задачу, а все пиксели будет относить к фону!

IoU и Dice

Нам нужна мера, которая бы вычисляла качество предсказания именно целевого класса. Самой популярной мерой является мера Жаккара, в компьютерном зрении называемая Intersection-over-Union или IoU.

Пусть

-

- множество пикселей, реально принадлежащих целевому классу,

-

- множество пикселей, отнесённых моделью к целевому классу.

Тогда качество выделения целевого класса считается как

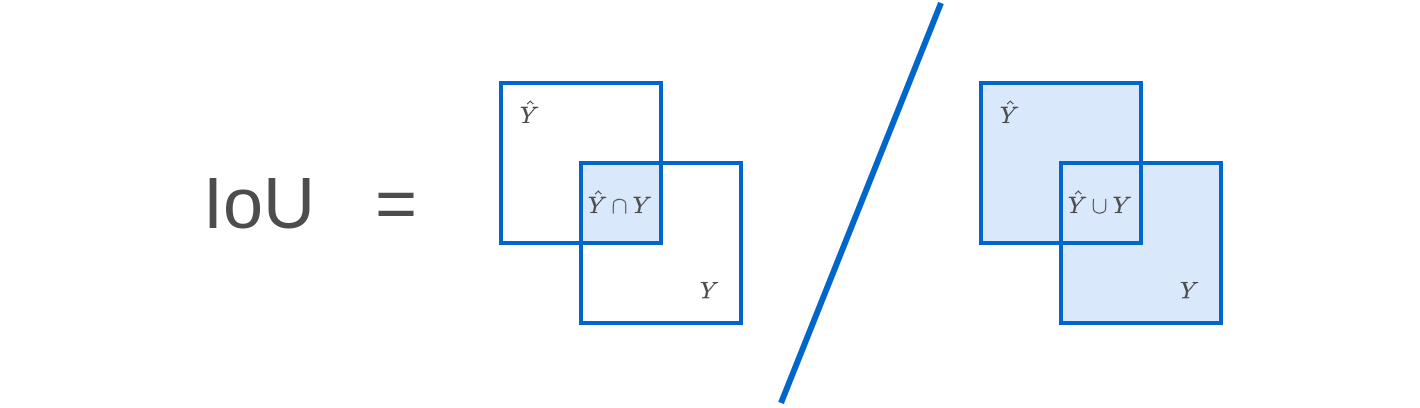

что графически можно представить следующим образом:

Также популярна мера качества Dice:

которая графически выглядит как

Из определения следует, что обе меры принимают значения из отрезка [0,1], причём

-

1 соответствует наилучшей сегментации (множества совпали),

-

0 соответствует наихудшей сегментации (множества не имеют пересечения).

Если целевой класс обозначить положительным, а фон - отрицательным классом, то в терминах величин TP, TN, FP, FN эти меры запишутся как

где

-

- число предсказаний целевого класса,

-

- число реальных пикселей целевого класса.

Поскольку в Dice, по сравнению с IoU, и в числителе, и в знаменателе прибавляется величина TP, то Dice будет выдавать более высокие значения для в целом верно распознанных регионов целевого класса:

По смыслу меры IoU и Dice измеряют одно и то же (качество выделения целевого класса) и связаны монотонным соотношением (докажите!):

Сглаженные варианты IoU и Dice

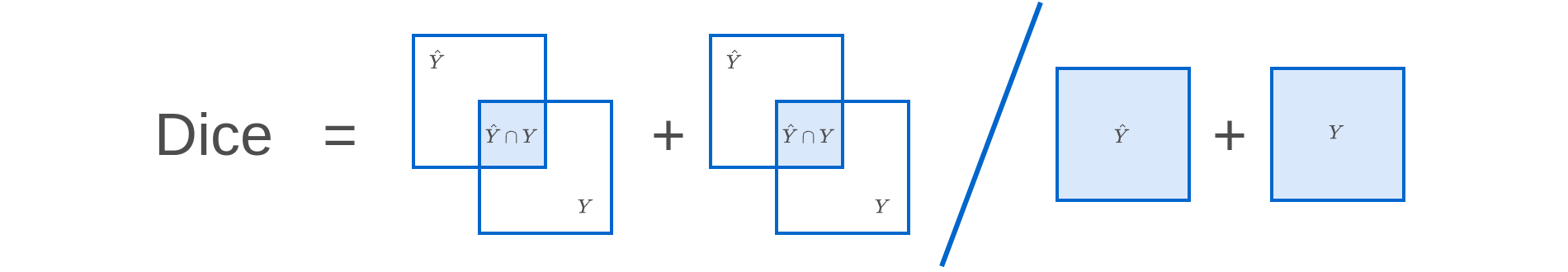

Поскольку сегментационная модель выдаёт не сами классы, а их вероятности, то имеет смысл обобщить меры IoU и Dice на оценку предсказываемых вероятностей, как показано на рисунке [1]:

Пусть теперь

-

- матрица истинной разметки, в которой 1 стоит в пикселях целевого класса, а 0 обозначает фон;

-

- матрица, каждый элемент которой задаёт предсказанную вероятность целевого класса в каждом пикселе.

Тогда меру IoU можно применять как [2]:

а меру Dice как

Преимуществом подобных мер является то, что они дифференцируемы по вероятностям, следовательно можно не только отслеживать по ним качество прогнозов, но и использовать их напрямую в настройке параметров модели как целевые критерии оптимизации.

В работе [2] рассматриваются и другие меры обобщения IoU на случай вероятностных прогнозов.

Пограничная IoU

Часто модель сегментации хорошо справляется с выделением объекта в целом, а большая часть ошибок концентрируется на границах объектов. Для детальной оценки качества сегментации именно на границах IoU применяется не по всему изображению, а только вдоль границ объек�тов.

Пусть

-

- полоса ширины вокруг границы реальной маски .

-

- полоса ширины вокруг границы предсказанной маски .

Тогда качество вдоль границ объектов можно оценивать одним из следующих способов [3]:

Average Precision

Можно варьировать порог вероятности , начиная с которого пикселю будет назначаться целевой класс (а не фон):

При более низком пороге целевой класс будет назначаться более часто.

При варьировании будут изменяться меры Precision и Recall.

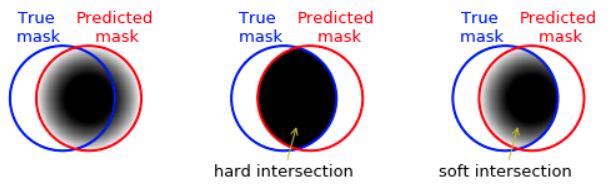

Агрегированной мерой качества сегментатора для различных порогов будет кривая зависимости Precision(Recall) при различных порогах , известная как кривая точности-полноты (precision-recall curve).

Пример этой кривой показан ниже [4]:

Агрегированной численной мерой качества для всевозможных порогов будет величина Average precision (AP), равная площади под графиком зависимости точности от полноты.

Случай многих классов

Если производится сегментация на классов, то оценивают качества выделения каждого класса одной из вышеприведённых мер, а затем меры для каждого класса усредняют. Величина Average Precision, равномерно усреднённая по классам, называется Mean Average Precision (mAP).

Литература

- ilmonteux.github.io: Metrics for semantic segmentation.

- Wang Z., Ning X., Blaschko M. Jaccard metric losses: Optimizing the jaccard index with soft labels //Advances in Neural Information Processing Systems. – 2024. – Т. 36.

- Cheng B. et al. Boundary IoU: Improving object-centric image segmentation evaluation //Proceedings of the IEEE/CVF conference on computer vision and pattern recognition. – 2021. – С. 15334-15342.

- geeksforgeeks.org: Precision-Recall Curve - ML.